L’Union européenne a peur. Pas seulement – à raison – des velléités impérialistes russes, mais aussi peur d’un déclassement dans la course à l’IA. Or, selon Mario Draghi, auteur d’un rapport souvent cité sur l’avenir de l’économie européenne paru le 9 septembre 2024, si l’Europe n’a pas (ou peu) de « champions » en matière d’IA, ce serait à cause d’un environnement juridique qui ne favoriserait pas la croissance. Il est vrai que, depuis 2019, nous avons assisté à un empilement impressionnants de textes visant à réglementer le fonctionnement de l’économie dite numérique, généralement connus sous leur nom anglais : Digital Operational Resilience Act, Data Act, Data Governance Act, Digital Services Act, Digital Markets Act, NIS2, eIDAS 2, AI Act… autant de textes qui s’additionnent sans qu’il y ait parfois de grande cohérence entre eux. Cela a deux effets : d’une part, la multiplication d’obligations qui, selon la logique de compliance[1]Favro, Karine. 2017. ‘La démarche de compliance ou la mise en œuvre d’une approche inversée’. LEGICOM N° 59(2): 21–28., imposent de coûteuses opérations d’audit, certification et contrôles internes et externes, mais aussi des risques de redondance dénoncées par une part de l’industrie et qui ont fait l’objet d’études commandées par les institutions de l’Union pour ce qui concerne la réglementation de l’IA[2]Graux, Hans, Krzysztof Garstka, Nayana Murali, Jonathan Cave, and Maarten Botterman. 2025. Interplay between the AI Act and the EU Digital Legislative Framework. Strasbourg: Parlement européen.. Pour autant, le retard que l’Europe aurait pris en la matière peut au moins tout autant s’expliquer par le cadre réglementaire – qui n’est pas inexistant aux États-Unis[3]Voir : Wendehorst, Christiane, Kyoko Yoshinaga, Alain Strowel, and Sebastian Schwamberger. 2024. Co-Generation of Data Copyright and Data Protection Rights in Co-Generated Input and Output of … Continue reading, et encore moins en Chine [4]Yang, Liping, Yiling Lin, and Bing Chen. 2024. ‘Practice and Prospect of Regulating Personal Data Protection in China’. Laws 13(6): 78. ! – mais peut-être aussi et surtout par notre incapacité chronique à investir à long-terme dans la recherche à hauteur des 12 milliards de dollars de pertes accumulées par OpenAI en un trimestre[5]Brown, Eliot. 2025. « OpenAI Made a $12 Billion Loss Last Quarter, Microsoft Results Indicate », The Wall Street Journal. Voir ici : … Continue reading. Mais prenons la Commission au mot ; les Digital Omnibos (si l’on décline le nom anglo-latin donné à ces textes) apportent-ils simplification et maintien d’un niveau de protection des droits et libertés identique à l’état actuel du droit ?

Le 21 mai, la Commission avait déjà proposé une petite réforme du RGPD[6]Voir : https://single-market-economy.ec.europa.eu/document/download/d88a75de-b620-4d8b-b85b-1656a9ba6b8a_en?filename=Proposal%20for%20a%20Regulation%20-%20Small%20mid-caps.pdf ; il s’agissait alors d’étendre à un plus grand nombre de PME le droit de ne pas avoir à tenir de registre de traitements de leurs données à caractère personnel. Sauf dans les cas où l’entreprise procède à des traitements qui engendrent un risque pour les personnes concernées, ce qui l’obligera tout de même à se poser la question, et qui ne l’exemptera pas de toutes les autres obligations.

Le 19 novembre 2025, la Commission européenne publiait cependant trois propositions de règlements qui vont beaucoup plus loin :

- le « Digital Omnibus[7]https://eur-lex.europa.eu/procedure/EN/2025_360 » ;

- le « Digital Omnibus IA[8]https://eur-lex.europa.eu/procedure/EN/2025_359 » ;

- et un projet de règlement sur les portefeuilles numériques pour les entreprises (Business Wallet[9]https://eur-lex.europa.eu/procedure/EN/2025_358).

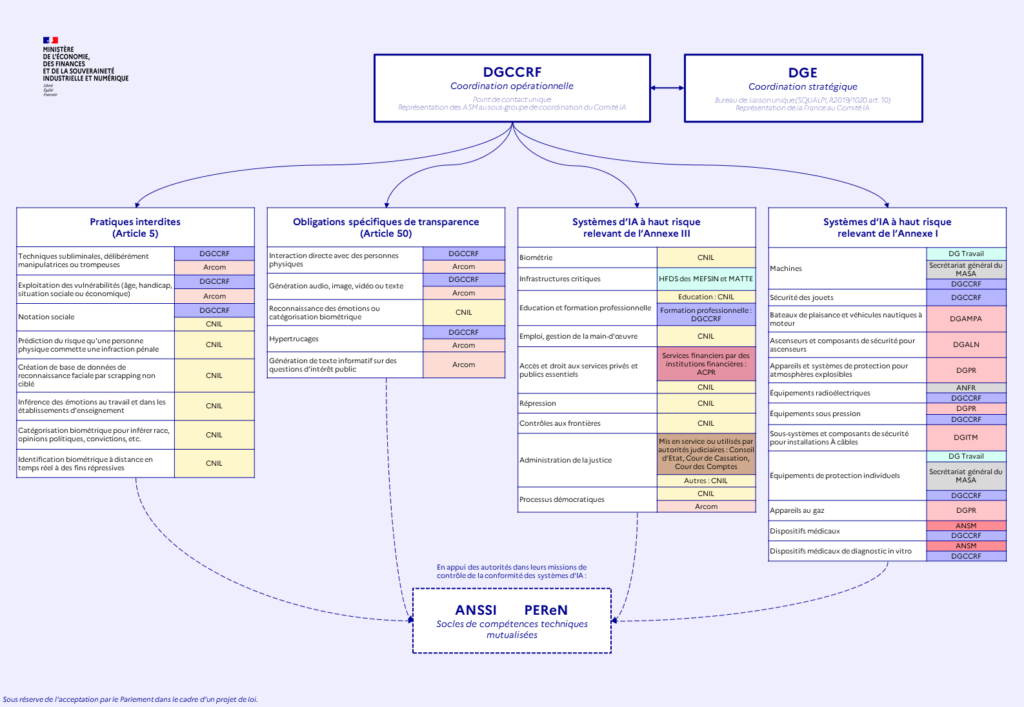

Je n’aborderai pas ici la troisième proposition, qui fait l’objet d’un suivi et d’une étude par la chaire Valeurs et politiques des informations personnelles[10]https://cvpip.wp.imt.fr/accueil/. La seconde concerne essentiellement un report de l’entrée en application des dispositions du règlement sur l’IA qui concernent les systèmes d’IA certes à hauts risques, mais pas interdits. Ce report est présenté comme la conséquence du retard – pas franchement surprenant – pris par la standardisation en matière d’IA. Il n’est cependant pas prévu de simplifier le système horriblement complexe de supervision du respect des dispositions de ce règlement, dont le fantastique schéma reproduit ci-dessous concerne seulement les autorités que la France envisage de désigner à ce titre, et pas toutes celles qui seront impliquées à l’échelle de l’UE, et oublie aussi de rappeler le rôle que les autorités de protection des données continueront à avoir compte tenu de leur compétence dès qu’un système d’IA traite des données à caractère personnel :

Source : https://www.entreprises.gouv.fr/priorites-et-actions/transition-numerique/soutenir-le-developpement-de-lia-au-service-de-0

Il y aurait certainement encore beaucoup à dire sur le coût de la conformité à un règlement IA qui ne crée même pas de droits nouveaux pour les personnes concernées, et dont plusieurs dispositions recoupent des obligations déjà présentes dans le RGPD. Bref, à chaud, rien de bien inquiétant pour les droits et libertés – puisque l’IA Act n’offrait pas vraiment de nouveaux droits subjectifs – mais, à terme, un simple report d’un cadre réglementaire complexe, confus, et vraisemblablement coûteux.

Examinons maintenant le Digital Omnibus simple (pas celui IA) (car oui, pourquoi faire simple quand il s’agit de simplifier quand on peut simplifier en complexifiant ?). Il vise à réformer plusieurs règlements : la directive 2002/58/CE (directive ePrivacy), le règlement 2016/679 (Règlement général de protection des données – RGPD), le règlement 2018/1724 établissant un portail numérique unique pour donner accès à des informations, à des procédures et à des services d’assistance et de résolution de problèmes, le règlement 2018/1725 (règlement EDPS sur le protection des données par les institutions de l’Union), la directive 2019/1024 (Open Data), le règlement 2022/868 (Data Governance Act), la directive 2022/2555 (NIS2), la directive 2022/2557 sur la résilience des entités critiques et le règlement 2023/2854 (Data Act). Les textes suivants sont abrogés, certaines dispositions étant reprises dans d’autres : le règlement 2018/1807 (Free Flow of Non-Personal Data Regulation), le règlement 2019/1024 concernant les données ouvertes et la réutilisation des informations du secteur public, le règlement 2019/1150 promouvant l’équité et la transparence pour les entreprises utilisatrices de services d’intermédiation en ligne (Platform to Business), et le règlement 2022/868 (Data Governance Act). Tout un programme mené tambour battant et sans évaluation d’impacts, souvent sur des textes récents, pour répondre, en théorie à un besoin de simplification, mais qui demandera certainement de poursuivre un effort considérable de la part de tous les destinataires de ces textes pour se tenir à jour de ce chamboulement.

Il est toujours périlleux de réagir à chaud, surtout que rien que le Digital Omnibus fait 153 pages en anglais. Mais compte tenu des enjeux, je me permets ici une première analyse des changements envisagés pour ce qui concerne le droit des données personnelles. Ceux-ci sont assez importants ; mais il reste encore de nombreuses interrogations.

La Commission veut s’arroger le pouvoir de restreindre à sa guise le champ d’application du RGPD

En 2016, le législateur européen a intégré au droit des données personnelles une nouvelle notion : celle de « pseudonymisation », définie à comme « le traitement de données à caractère personnel de telle façon que celles-ci ne puissent plus être attribuées à une personne concernée précise sans avoir recours à des informations supplémentaires […] » (art. 4 (5) du RGPD). Cela permettait à la fois d’intégrer un encouragement à pseudonymiser les données dans la mesure du possible, tout en rappelant qu’elles sont toujours susceptibles d’être plus ou moins facilement ré-identifiées. Or, les groupes d’intérêts industriels avaient très tôt exprimé leur souhait de voir retirer dans la définition des données personnelles toutes les données indirectement identifiantes. C’est pratique : on peut connaître la date de naissance d’une personne, toutes ses données de géolocalisation, peut-être ses habitudes d’achat… et donc être capable de la cibler, et de l’identifier avec des efforts parfois très minimaux[11]Voir les travaux du LINC, le labo de la CNIL, à ce sujet : https://linc.cnil.fr/geo-trouve-tous-la-reidentification-des-donnees-de-la-theorie-au-cas-pratique, mais on s’évite d’avoir à respecter la moindre règle. C’est très dangereux. En effet, cela voudrait dire que l’on pourrait librement faire commerce, sans mesure particulière de sécurité, de données de géolocalisation qui révèlent par exemple les adresses personnelles des gens fréquentant tel ou tel lieu de culte. En d’autres termes, cela veut dire que l’on légalise le commerce de liste de Juifs, de Chrétiens ou de Musulmans… mais attention, les courtiers qui vendent ces données n’auraient aucune règle à respecter ! Absurde et dangereux, et d’ailleurs, le RGPD, tel qu’adopté en 2016, précise bien qu’il s’applique aussi aux données pseudonymes.

L’article 3 (1) de Digital Omnibus propose d’ajouter les lignes suivantes à la définition des données à caractère personnel :

« Information relating to a natural person is not necessarily personal data for every other person or entity, merely because another entity can identify that natural person. Information shall not be personal for a given entity where that entity cannot identify the natural person to whom the information relates, taking into account the means reasonably likely to be used by that entity. Such information does not become personal for that entity merely because a potential subsequent recipient has means reasonably likely to be used to identify the natural person to whom the information relates.’ »

Selon la Commission européenne, il ne s’agirait que de la codification de la jurisprudence de la Cour de justice de l’Union européenne. En septembre 2025[12]CJUE 4 septembre 2025. CEPD contre SRB. Aff. C-413/23 P, elle a en effet que « la perspective pertinente pour apprécier le caractère identifiable de la personne concernée dépend essentiellement des circonstances caractérisant le traitement des données dans chaque cas particulier. » Mais tout ceci n’est que la continuité d’un arrêt de 2016[13]CJUE 19 octobre 2016. Breyer. Aff. C-582/14, dans lequel il avait été jugé que :

« […] une adresse de protocole Internet dynamique enregistrée par un fournisseur de services de médias en ligne à l’occasion de la consultation par une personne d’un site Internet que ce fournisseur rend accessible au public constitue, à l’égard dudit fournisseur, une donnée à caractère personnel au sens de cette disposition, lorsqu’il dispose de moyens légaux lui permettant de faire identifier la personne concernée grâce aux informations supplémentaires dont dispose le fournisseur d’accès à Internet de cette personne. »

Sauf qu’opérationnellement, cela ne change pas grand-chose. Reprenons cet exemple des adresses IP. Certaines sont statiques, et liées à un abonné qui est une personne physique, d’autres sont dynamiques, et difficiles à ré-identifier sans croisement avec des données détenues par les fournisseurs d’accès à Internet[14]Les FAI qui participent en France au service Utiq fournissent d’ailleurs bien volontiers ces données, d’autres enfin sont des IP de sortie derrière lesquelles se trouvent de milliers d’utilisateurs… mais reste qu’il est plus facile et moins coûteux de considérer que toutes les informations liées à des adresses IP sont personnelles, plutôt que d’essayer de distinguer ce qui l’est de ce qui ne l’est pas. De toutes façons, ce n’est pas parce qu’une donnée est à caractère personnel qu’il est interdit de la traiter, tant qu’on procède à un traitement licite.

Une autre difficulté opérationnelle soulevée par cette définition est que, pour pouvoir décider que le RGPD ne s’applique pas à une situation donnée, il faut évaluer si « l’entité » dispose des « moyens raisonnables » pour identifier les personnes physiques présentes dans le jeu de données, ou pas. Tout un programme ! D’autant que ces « moyens raisonnables » peuvent varier au cours du temps. Il faudrait donc suivre constamment, au sein de l’entité, quels jeux de données sont susceptibles, à un moment donné, de basculer de « pas-RGPD » à « RGPD ». Simplification ? Pas sûr.

Plus étonnant encore, cette définition parle « d’entités ». Qui sont-elles ? Le RGPD, jusqu’ici, connaissait trois catégories de personnes sujettes de droits ou de devoirs : les « personnes concernées » (qui ont des droits) d’une part, et les « responsables du traitement » et « sous-traitants » d’autre part. Là, on ne sait pas bien qui sont ces « entités ». C’est d’autant plus complexe à comprendre et appréhender que toute personne ayant un tout petit peu fait de conformité RGPD sait qu’il existe en pratique un grand nombre de situations de responsabilité conjointe, où plusieurs « entités » déterminent les modalités et finalités d’un traitement. D’ailleurs, l’extension très large de la notion de responsabilité conjointe avait fait l’objet d’interrogations et de critiques[15]Millard, Christopher, Christopher Kuner, Fred H. Cate, Orla Lynskey, Nora Ni Loideain, and Dan Jerker B. Svantesson. 2019. ‘At This Rate, Everyone Will Be a [Joint] Controller of Personal Data!’ … Continue reading et on aurait pu attendre de la simplification, ou au moins de la clarification, de ce côté-là. Justement, pour éviter aux PME qui n’ont pas le choix des solutions logicielles qui leur sont imposées de se retrouver comptables des bêtises faites par ces géants du numérique auxquels elles sont pieds et poings liés… mais je m’égare. La relation de cette digression à la nouvelle proposition de définition de la notion de donnée personnelle, c’est qu’en pratique, les traitements sont réalisés conjointement par plusieurs « entités » qui, ensemble, sont capables d’identifier les personnes dans leurs jeux de données, même si chacune séparément ne le pourrait peut-être pas toujours. Dans ces situations, avec la nouvelle définition : donnée personnelle, ou pas ? Pas clair. Donc : complexe. Il va falloir payer des consultants et des avocats pour y réfléchir. Puis, il y aura du contentieux en cas de problème. Peut-être un marché à conquérir pour les LegalTech, pas sûr que le reste de l’industrie apprécie tant que ça…

Il serait également illusoire d’imaginer que cette nouvelle prose ajoutée à la définition de la notion de donnée à caractère personnel serait neutre pour les droits et libertés. En effet, même si, comme je le disais, opérationnellement, cela ne concernerait qu’un très petit nombre de jeux de données réels, beaucoup de ces mystérieuses « entités », et peut-être même la majorité des responsables du traitement dont les opérations sont susceptibles d’être contestées, vont essayer de s’y appuyer pour essayer d’échapper à toute responsabilité. Alors, derechef, il y aura du contentieux. Les juridictions, déjà bien engorgées, apprécieront. Surtout si cela entraîne un report de celui-ci du droit public ou du droit civil des données personnelles, pour se reporter sur le droit pénal. Lequel existe (même si on l’oublie), prévoit des peines théoriques élevées (en tout cas en France), ne relève pas du droit de l’Union, et devrait en toute logique, dans son interprétation, tenir compte de la définition de la notion de donnée personnelle que l’on trouve dans une convention internationale ratifiée par tous les États de l’Espace économique européen : la Convention 108. Bref : mauvais pour les droits ; nul pour la sécurité juridique (y compris des patrons et patronnes de PME/TPE concerné⋅es) et la cohérence générale du droit des données personnelles.

Mais il y a encore bien pire. Car la Commission européenne espère, par l’ajout d’un article 41(a) dans le RGPD, s’arroger le droit de dire dans quelles situations une donnée pseudonymisée n’est plus personnelle « pour certaines entités ». En clair : elle souhaite s’arroger le pouvoir du législateur pour modifier à sa guise le champ d’application d’un règlement qui sert à garantir le respect d’un droit garanti par la Charte des droits fondamentaux de l’Union européenne. C’est peut-être là l’une des dispositions les plus dangereuses du Digital Omnibus. La seconde série de dispositions vraiment choquantes concernent les droits des personnes concernées, que la Commission veut vider de sa substance.

Une atteinte grave aux droits des personnes concernées… sans simplification notable ?

Depuis qu’il existe un droit des données personnelles, inventé par le Land de Hesse en 1970, un des piliers de celui-ci est de reconnaître à chaque personne physique des droits au regard des données qui sont traitées à son sujet : droit d’en être informé, d’y accéder, de demander la rectification, de s’opposer au traitement ou de demander l’effacement dans certains cas. Ces droits se retrouvent dans la Convention 108 du Conseil de l’Europe, dans le RGPD, mais aussi dans le droit de l’écrasante majorité des plus de 170 pays qui se sont dotés d’une législation contraignante en matière de données personnelles dans le monde[16]Greenleaf, Graham. 2025. ‘Global Data Privacy Laws 2025: 172 Countries, Twelve New in 2023/24’. doi:10.2139/ssrn.5275559..

Or, le Digital Omnibus propose de changer la rédaction de l’article 12 du RGPD pour permettre à un responsable du traitement de refuser de donner droit à la demande d’une personne d’accéder à ses données dès lors qu’elle ne justifierait pas qu’elle le fait pour une finalité en lien avec des objectifs de protection de ces données. Cela va à l’encontre de l’évolution de la jurisprudence, qui rappelle qu’en l’état actuel, les demandes n’ont pas besoin d’être motivées. C’est par ailleurs absurde. Dans une société régie par des logiques de mises en données des individus, le fait qu’elles soient traitées de manière transparente est une manière de garantir la confiance, et d’éviter des asymétries d’information au détriment des individus. C’est aussi reconnaître que les données qui portent sur un individu sont un attribut de sa personnalité et que, très concrètement, elles peuvent toujours lui être utiles pour des finalités autre que celles du responsable du traitement.

De toutes façons, opérationnellement, il n’y a là aucune simplification. Au contraire. En effet, une personne pourra toujours dire qu’elle veut vérifier la licéité et l’exactitude des données traitées au moment où elle demande une copie. Qui pourra vérifier ou contester ? Bien sûr, les responsables du traitement qui auront des choses à cacher refuseront systématiquement de donner suite, en se fondant sur les nouvelles dispositions proposées par la Commission. Cela engendrera des plaintes qui iront encombrer les autorités de protection des données et les juridictions, et donnera du travail supplémentaire à tout le monde. Tout ceci sera encore complexifié par le fait que ce n’est pas cohérent avec la Convention 108 du Conseil de l’Europe – que les États sont tenus de respecter – ni avec l’article 8 de la Charte des droits fondamentaux de l’Union européenne, qui ne prévoit pas de soumettre à une liste limitée d’objectifs le droit d’accès des personnes concernées. Tout ça pour un droit dont les études scientifiques montrent que quoique très utile[17]Hase, Valerie, Jef Ausloos, Laura Boeschoten, Nico Pfiffner, Heleen Janssen, Theo Araujo, Thijs Carrière, et al. 2024. ‘Fulfilling Data Access Obligations: How Could (and Should) Platforms … Continue reading, il demeure largement sous-utilisé[18]Sur la base de témoignages de DPO avec qui j’ai échangés, et de retours faits par les entreprises et administrations que j’ai précédemment conseillées pour leur conformité RGPD. Sur … Continue reading.

L’absence de simplification se retrouve aussi dans la proposition de modification de l’article 13 du RGPD. La Commission souhaite rendre facultative la fourniture d’informations aujourd’hui obligatoires, notamment sur les raisons pour lesquelles des données sont traitées, leur étendue, les destinataires, etc. lorsque la collecte se fait dans le contexte d’une « relation claire et circonscrite » avec un responsable du traitement qui « exerce une activité qui n’est pas intensive en données. » Qu’est-ce que ça veut dire ? On ne sait pas. Mais on peut déjà parier que des cabinets d’experts en RGPD vont se régaler à l’idée de rédiger des études d’impacts pour savoir si un responsable du traitement a le droit de cacher aux personnes sur lesquelles il collecte des données les raisons pour lesquelles il le fait. Ça va coûter du temps, de l’argent… alors que, justement, l’article 13 est l’une des articles les plus clairs et les simples à mettre en œuvre du RGPD.

Résultat : la Commission souhaite complexifier les choses tout en multipliant lourdement les obstacles à l’exercice des droits des personnes.

Décisions automatisées

La Commission européenne souhaite aussi s’attaquer à l’article 22 du RGPD. Sa formulation alambiquée a fait couler beaucoup d’encre, mais elle aboutit à une interdiction de principe et de fait des décisions purement automatisées. C’est cohérent avec le principe d’avoir toujours un « humain dans la boucle » soutenu par la Commission elle-même et qui s’est retrouvé inscrit dans le règlement sur l’IA, qui lui-même contient des règles sur le droit à l’explication des décisions individuelles… si elles ne sont pas couvertes ailleurs par le droit de l’UE, ce qui risque de devenir pour partie le cas si l’Omnibus n’est pas stoppé.

Je concède néanmoins volontiers que la nouvelle formulation de l’article 22 proposée par cet attelage autrement très brinquebalant soit plus claire. Mais l’une des conditions qui autoriserait une telle mesure paraît elle aussi peu claire. En effet, les décisions automatisées seraient autorisées si c’est :

« necessary for entering into, or performance of, a contract between the data subject and a data controller regardless of whether the decision could be taken otherwise than by solely automated means; »

Une telle formulation est contradictoire. Soit l’automatisation de la prise de décision est nécessaire, ce qui implique qu’elle ne peut pas être prise de manière non-automatisée ; soit elle ne l’est pas. Du coup, la nouvelle rédaction proposée pour l’article 22 ne fait que déplacer l’endroit dans le texte où c’est alambiqué. Pas sûr que ça ait d’intérêt pour qui que ce soit.

Intérêt légitime et entraînement de systèmes d’IA

Pour traiter des données personnelles, il faut y être autorisé par l’une des bases légales de l’article 6 paragraphe 1 du RGPD. La plus connue est celle du consentement (libre, éclairé, spécifique, retirable à tout moment, etc.) ; mais ce n’est pas la seule. Il est aussi possible de traiter des données pour poursuivre un intérêt légitime du responsable du traitement ou d’un tiers. La CJUE a déjà jugé, dans son fameux arrêt sur le droit au déréférencement[19]CJUE 13 mai 2014. Google Espagne. Aff. C-131/12. que Google avait un intérêt légitime à indexer des pages web contenant des données personnelles dans son moteur de recherche. Ça ne veut pas dire que l’on puisse tout faire avec l’intérêt légitime. Mais le raisonnement à respecter n’interdit pas tout usage de cette base légale pour entraîner des IA. Le Comité européen de protection des données l’a bien rappelé dans un avis de 2024 sur le sujet[20]Avis 28/2024 relatif à certains aspects de la protection des données liés au traitement de données à caractère personnel dans le contexte des modèles d’IA, disponible ici : … Continue reading.

Cela soulève tout de même deux difficultés. La première, c’est ce que quand un responsable du traitement invoque un intérêt légitime pour traiter des données personnelles sans consentement opt-in, il doit néanmoins s’assurer d’offrir un opt-out. C’est le droit d’opposition. Peut-on exercer son droit d’opposition en matière d’IA ? Peut-on retirer les données d’un modèle entraîné ? C’est une difficulté pratique, mais que la proposition de la commission ne lève pas. Plutôt un sujet pour la recherche (mais la recherche, aïe, ça coûte des sous !).

Une seconde difficulté, c’est que l’intérêt légitime ne permet de traiter des données sensibles sans consentement. Il s’agit des données visées à l’article 9 du RGPD, et qui révèlent des choses, par exemple, sur l’opinion politique ou les croyances religieuses, ou encore sur l’orientation sexuelle ou la santé d’une personne. Or, comment savoir, par exemple, si un système discrimine sur le fondement de la santé ou de la religion si on ne vérifie pas les résultats d’une IA au regard de telles données ? Le règlement IA contient déjà, pour y répondre, un article 10 paragraphe 5 qui le permet, dès lors que de telles données sont traitées dans le but de réduire au maximum les biais du système d’IA que l’on entraîne. Or, dans le Digital Omnibus IA on a la proposition de l’insertion d’un article 4a dans le règlement IA pour disposer que :

Article 4a

Processing of special categories of personal data for bias detection and mitigation

1. To the extent necessary to ensure bias detection and correction in relation to high-risk AI systems in accordance with Article 10 (2), points (f) and (g), of this Regulation, providers of such systems may exceptionally process special categories of personal data, subject to appropriate safeguards for the fundamental rights and freedoms of natural persons. In addition to the safeguards set out in Regulations (EU) 2016/679 and (EU) 2018/1725 and Directive (EU) 2016/680, as applicable, all the following conditions shall be met in order for such processing to occur:

(a) the bias detection and correction cannot be effectively fulfilled by processing other data, including synthetic or anonymised data;

(b) the special categories of personal data are subject to technical limitations on the re-use of the personal data, and state-of-the-art security and privacy-preserving measures, including pseudonymisation;

(c) the special categories of personal data are subject to measures to ensure that the personal data processed are secured, protected, subject to suitable safeguards, including strict controls and documentation of the access, to avoid misuse and ensure that only authorised persons have access to those personal data with appropriate confidentiality obligations;

(d) the special categories of personal data are not transmitted, transferred or otherwise accessed by other parties;

(e) the special categories of personal data are deleted once the bias has been corrected or the personal data has reached the end of its retention period, whichever comes first;

(f) the records of processing activities pursuant to Regulations (EU) 2016/679 and (EU) 2018/1725 and Directive (EU) 2016/680 include the reasons why the processing of special categories of personal data was necessary to detect and correct biases, and why that objective could not be achieved by processing other data.

2. Paragraph 1 may apply to providers and deployers of other AI systems and models and deployers of high-risk AI systems where necessary and proportionate if the processing occurs for the purposes set out therein and provided that the conditions set out under the safeguards set out in this paragraph

Cela ajoute du texte pour rappeler des choses qui n’ont pas forcément, à mon avis, besoin d’être rappelées (mais je veux bien qu’on m’écrive pour m’expliquer l’intérêt de ce verbillage supplémentaire). Donc, on rajoute de la complexité. On simplifie rien du tout, en fait.

À ce sujet, on voit une tendance générale se dégager des Omnibos, qui consiste à la fois à vider les droits des personnes concernées de leur substance, à conférer des pouvoirs exorbitants à la Commissions qui remettent en cause l’indépendance des autorités de contrôle… mais en même temps, on surprécise, on rallonge, bref, on complexifie, on ajoute de l’incertitude, on invente de nouveaux concepts (encore) sans rapport avec l’architecture de ce droit. Donc : on crée autant de zones grises, de nouvelles interprétations possibles qui restreignent les droits tout en augmentant le risque de contentieux. Contentieux qui décourage les nouveaux entrants, tout en confortant dans leurs positions dominantes ceux qui ont les moyens de payer des cabinets d’avocats, et de perdre un procès ou deux de temps en temps.

À la place, le RGPD prévoit toujours la possibilité pour le secteur de travailler sur des codes de conduite, qui opérationnalisent les règles et principes généraux du règlement dans des cas concrets. Leur intérêt est de favoriser le dialogue entre des autorités indépendantes et le secteur concerné, au lieu de tout spécifier dans des textes législatifs qui seront beaucoup plus difficiles à mettre à jour.

Autres propositions

On retrouve dans le Digital Omnibus d’autres propositions. Certaines concernent la recherche : le texte précise de manière inutile que les exceptions à des fins de recherche scientifique peuvent être valablement mobilisées par la R&D commerciale. De manière générale, ma conviction personnelle est qu’un texte court et clair, surtout appuyé par de la jurisprudence constante, ne devrait pas être modifié. Mais pourquoi pas. Il est vrai que même si un arrêt de la CJUE de 2008[21]CJUE 16 décembre 2008. Huber contre Allemagne. Aff. C-524/06. avait posé le principe selon lequel il fallait regarder la finalité du traitement pour déterminer si une exception liée à celle-ci (en l’espèce : le traitement statistique) est applicable, et non pas la nature du responsable du traitement, d’autres textes, dont la directive sur le droit d’auteur de 2019 et le DSA limitent les exceptions de recherche scientifique à une définition qui en exclue les organismes à but lucratif.

Par ailleurs, de manière nettement plus inquiétante, la Commission veut de nouveau essayer de s’attaquer à l’indépendance – protégée par l’article 8 de la Charte des droits fondamentaux de l’Union européenne – des autorités de protection des données, en fixant elle-même les listes des traitements pour lesquels des évaluations d’impacts au titre du RGPD sont ou non nécessaires. On voit comment elle souhaite reprendre le contrôle politique du droit des données personnelles, là où le fait d’en confier la supervision à des autorités administratives indépendantes était l’une des clefs devant garantir la confiance dans le développement de l’informatique… et ce, depuis les années 1970.

Des simplifications sont prévues sur la notification aux autorités compétentes des violations de données, pour ajouter de la cohérence – pas si malvenue – avec d’autres textes relatifs à la cybersécurité. Mais on passe sans explication de 72 heures à 96 heures de délai.

Enfin, plusieurs dispositions visent à réformer la directive ePrivacy, notamment en intégrant dans le régime du RGPD les règles relatives aux « cookies. » Cela permet d’intégrer ces règles dans le régime de l’autorité cheffe-de-file instauré par le règlement et qui, en effet, apporte de la simplification aux responsables du traitement, qui bénéficient depuis d’une autorité interlocutrice unique dans la plupart des cas. Il est aussi prévu de permettre à la Commission de confier aux organismes européens de standardisation le soin de rédiger un standard technique permettant l’expression des préférences en matière de vie privée, sur le modèle de ce qu’auraient dû être P3P ou Do Not Track. Ces propositions mériteront une analyse à part.

Un risque majeur pour les droits fondamentaux… et pour la compétitivité européenne ?

À l’issue de la lecture des propositions de modifications du RGPD, un constat s’impose : ce texte ne propose pas de simplification réelle, bien au contraire. Il complexifie, tout en vidant le texte de sa substance. Cela ne pourra que renforcer la défiance envers le numérique que l’on constate déjà à l’échelle de nombreuses études de sociologie. Selon une étude du BSI (l’Afnor britannique), près de la moitié des jeunes britanniques déclarent ainsi qu’ils auraient préféré vivre dans un monde sans Internet[22]Lire le rapport ici : https://www.bsigroup.com/siteassets/pdf/en/insights-and-media/insights/white-papers/gl-grp-cross-brand-nss-dt-mpd-mp-copolco-0525-broc.pdf ! Cela revient aussi à récompenser les responsables du traitement dont le modèle d’affaires ne respecte pas les droits des personnes, et à punir ceux qui ont investi dans la conformité, en vain. Pire, si le Digital Omnibus était voté en l’état, nous n’aurions plus, en Europe, les lois les plus protectrices en matière de protection des données. Contrairement à une idée reçue nombriliste et ethnocentrée mais très répandue, l’Europe n’est absolument pas le seul pays du monde à avoir des lois de protection des données. De plus, bien que, bien sûr, notre nombril soit magnifique, ce n’est pas seulement pour faire plaisir à notre soi-disant grande œuvre civilisatrice que ces pays ont légiféré. Or, certaines de ces lois contiennent des dispositions qui interdisent le transfert vers des pays moins-disants en matière de protection des données. C’est le cas, par exemple, du chapitre V de la loi brésilienne sur la protection des données. Jusqu’ici, une entreprise vraiment conforme au RGPD pouvait accéder aux marchés du monde entier du fait que ce texte est perçu (à tort ou à raison, je n’ai pas eu l’occasion de vérifier) comme le plus protecteur au monde. Investir dans le RGPD, c’était donc investir dans la conformité avec pratiquement la terre entière. Demain, cela risque de ne plus être le cas ; et ça, ça sera un vrai coup pour la compétitivité de l’industrie européenne du numérique. Tout en dérégulant en pratique considérablement l’accès aux données personnelles produites sur le territoire européen, y compris aux boîtes étrangères (que ce soit pour entraîner des IA, ou nous espionner[23]En octobre 2024, la presse française révélait que les gardes du corps d’Emmanuel Macron partageaient leurs données sur leurs activités sportives, ce qui donnait des indications sur les … Continue reading). Sans que ne soit réglée la question du financement de la recherche (publique ou privée) et de l’innovation, qui suppose, si on veut faire concurrence aux grosses startups américaines ou chinoises, d’éponger des milliards d’euros de perte pendant de longue années. Avec de la dette. Sans revendre tout à vil prix dès que ça commence à devenir rentable. Aïe !

| ↑1 | Favro, Karine. 2017. ‘La démarche de compliance ou la mise en œuvre d’une approche inversée’. LEGICOM N° 59(2): 21–28. |

| ↑2 | Graux, Hans, Krzysztof Garstka, Nayana Murali, Jonathan Cave, and Maarten Botterman. 2025. Interplay between the AI Act and the EU Digital Legislative Framework. Strasbourg: Parlement européen. |

| ↑3 | Voir : Wendehorst, Christiane, Kyoko Yoshinaga, Alain Strowel, and Sebastian Schwamberger. 2024. Co-Generation of Data Copyright and Data Protection Rights in Co-Generated Input and Output of Generative AI. Global Partnership on Artificial Intelligence. |

| ↑4 | Yang, Liping, Yiling Lin, and Bing Chen. 2024. ‘Practice and Prospect of Regulating Personal Data Protection in China’. Laws 13(6): 78. |

| ↑5 | Brown, Eliot. 2025. « OpenAI Made a $12 Billion Loss Last Quarter, Microsoft Results Indicate », The Wall Street Journal. Voir ici : https://www.wsj.com/livecoverage/stock-market-today-dow-sp-500-nasdaq-10-31-2025/card/openai-made-a-12-billion-loss-last-quarter-microsoft-results-indicate-e71BLjJA0e2XBthQZA5X |

| ↑6 | Voir : https://single-market-economy.ec.europa.eu/document/download/d88a75de-b620-4d8b-b85b-1656a9ba6b8a_en?filename=Proposal%20for%20a%20Regulation%20-%20Small%20mid-caps.pdf |

| ↑7 | https://eur-lex.europa.eu/procedure/EN/2025_360 |

| ↑8 | https://eur-lex.europa.eu/procedure/EN/2025_359 |

| ↑9 | https://eur-lex.europa.eu/procedure/EN/2025_358 |

| ↑10 | https://cvpip.wp.imt.fr/accueil/ |

| ↑11 | Voir les travaux du LINC, le labo de la CNIL, à ce sujet : https://linc.cnil.fr/geo-trouve-tous-la-reidentification-des-donnees-de-la-theorie-au-cas-pratique |

| ↑12 | CJUE 4 septembre 2025. CEPD contre SRB. Aff. C-413/23 P |

| ↑13 | CJUE 19 octobre 2016. Breyer. Aff. C-582/14 |

| ↑14 | Les FAI qui participent en France au service Utiq fournissent d’ailleurs bien volontiers ces données |

| ↑15 | Millard, Christopher, Christopher Kuner, Fred H. Cate, Orla Lynskey, Nora Ni Loideain, and Dan Jerker B. Svantesson. 2019. ‘At This Rate, Everyone Will Be a [Joint] Controller of Personal Data!’ International Data Privacy Law 9(4): 217–19 ; voir aussi : Rossi, Julien, and Jonathan Keller. 2025. ‘Are Internet Standard Developing Organisations Data Controllers under the GDPR?’ Internet Policy Review 14(3). |

| ↑16 | Greenleaf, Graham. 2025. ‘Global Data Privacy Laws 2025: 172 Countries, Twelve New in 2023/24’. doi:10.2139/ssrn.5275559. |

| ↑17 | Hase, Valerie, Jef Ausloos, Laura Boeschoten, Nico Pfiffner, Heleen Janssen, Theo Araujo, Thijs Carrière, et al. 2024. ‘Fulfilling Data Access Obligations: How Could (and Should) Platforms Facilitate Data Donation Studies?’ Internet Policy Review 13(3). doi:10.14763/2024.3.1793. ; Mahieu, René, Hadi Ashgari, and Michel van Eeten. 2018. ‘Collectively Exercising the Right of Access: Individual Effort, Societal Effect’. Internet Policy Review 7(3). doi:https://doi.org/10.14763/2018.3.927 ; Pidoux, Jessica, Paul-Olivier Dehaye, and Jacob Gursky. 2024. ‘Governing Work through Personal Data: The Case of Uber Drivers in Geneva’. First Monday. doi:10.5210/fm.v29i2.13576 ; Habu, Adamu Adamu, and Tristan Henderson. 2023. ‘Data Subject Rights as a Research Methodology: A Systematic Literature Review’. Journal of Responsible Technology 16: 100070. doi:10.1016/j.jrt.2023.100070 ; Petelka, Justin, Elisa Oreglia, Megan Finn, and Janaki Srinivasan. 2022. ‘Generating Practices: Investigations into the Double Embedding of GDPR and Data Access Policies’. Proceedings of the ACM on Human-Computer Interaction 6(CSCW2): 1–26. doi:10.1145/3555631 ; etc. |

| ↑18 | Sur la base de témoignages de DPO avec qui j’ai échangés, et de retours faits par les entreprises et administrations que j’ai précédemment conseillées pour leur conformité RGPD. Sur l’accès aux images de vidéosurveillance en particulier, voir ce papier de Marine Lamare : Lamare, Marine. 2024. ‘Droit d’accès Aux Images de Vidéosurveillances : Ineptie d’un Concept Ou Tactique Discursive ?:’ Droit et société n° 117(2): 229–48. doi:10.3917/drs1.117.0213. |

| ↑19 | CJUE 13 mai 2014. Google Espagne. Aff. C-131/12. |

| ↑20 | Avis 28/2024 relatif à certains aspects de la protection des données liés au traitement de données à caractère personnel dans le contexte des modèles d’IA, disponible ici : https://www.edpb.europa.eu/system/files/2025-05/edpb_opinion_202428_ai-models_fr.pdf. |

| ↑21 | CJUE 16 décembre 2008. Huber contre Allemagne. Aff. C-524/06. |

| ↑22 | Lire le rapport ici : https://www.bsigroup.com/siteassets/pdf/en/insights-and-media/insights/white-papers/gl-grp-cross-brand-nss-dt-mpd-mp-copolco-0525-broc.pdf |

| ↑23 | En octobre 2024, la presse française révélait que les gardes du corps d’Emmanuel Macron partageaient leurs données sur leurs activités sportives, ce qui donnait des indications sur les déplacements à venir du chef de l’État, via Strava. L’entreprise n’était pas incriminée. Mais la proposition du Digital Omnibus va encourager les interprétations qui diront qu’un jeu de données comportant toutes les données de géolocalisation des gardes du corps du président mais pas leurs noms sont des données pseudonymisées, pas personnelles du point de vue de l’entité qui les collecte… qui, dès lors, peut revendre librement ces données sans se soucier du RGPD ? Les services de renseignement des pays qui ne nous veulent pas que du bien seront ravies de soutenir cette interprétation. |